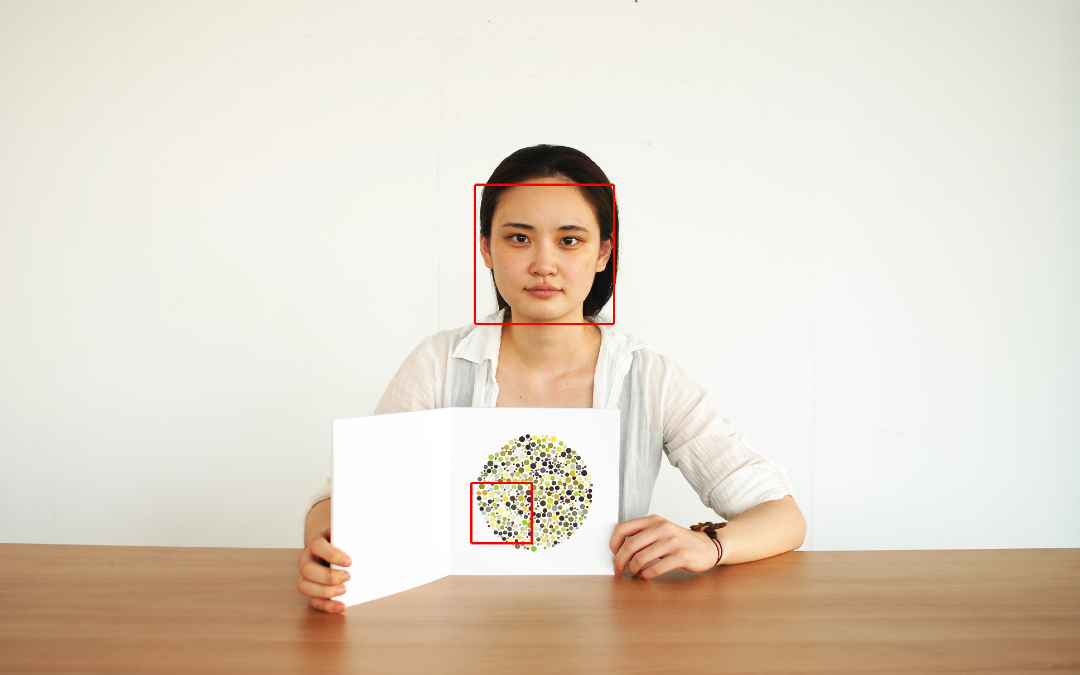

El diseño, desarrollo, venta y uso de tecnologías de reconocimiento de emociones no es consistente con el marco internacional de los derechos humanos, alerta la organización Artículo 19 en un reporte recién publicado sobre el uso de esta tecnología en China y su impacto.

De acuerdo con la organización, en este país el reconocimiento de emociones se está usando en una gran variedad de contextos, desde la seguridad pública, para identificar a personas sospechosas, como también para monitorear qué tan bien están rindiendo estudiantes en clase y determinar el acceso de las personas a crédito.

Artículo 19 hace énfasis en que China debe convertirse en una alerta para la comunidad internacional sobre cómo se utiliza esta tecnología y también cómo se está mercadeando, además de que el tiempo actual es crucial para poder llevar a cabo una defensa, antes de que estas tecnologías se conviertan en habituales.

“Los estudiantes de preparatoria no deberían temer a la recolección de datos sobre sus niveles de concentración y emociones, así como las evaluaciones emocionales de sospechosos que estén bajo interrogación de la policía tampoco deben ser utilizadas en su contra durante investigaciones”, aseguró Vidushi Marda, abogada e investigadora de la organización.

Marda alerta que es imperativo que se muestre cómo se están usando estas tecnologías y evalúe el impacto que tendrían internacionalmente antes de que se vuelvan más comunes, pero ante su incompatibilidad con los derechos humanos, la organización pide que sean prohibidas por completo.

El reporte también hace hincapié en las bases pseudocientíficas y racistas de este tipo de tecnologías, por lo que son simplemente insostenibles; más aún cuando son las corporaciones de seguridad quienes se ven más atraídas a utilizarlas, como herramientas para supuestamente prevenir comportamientos y como herramientas de interrogación.

Finalmente, Artículo 19 señala que mientras las empresas de tecnología destacan el “potencial” de sus productos, no atacan las posibles consecuencias discriminatorias de la recolectar información sobre salud mental y raza, en conjunto con los datos sobre emociones.

Imagen de Ars Electronica (CC BY-NC-ND 2.0)